小计: € 2,988.00

数据中心热能再利用:热水冷却

在本系列中,我们正在探索数据中心运营商尝试成为负责任的全球公民的不同方式,同时通过捕获和再利用其 ICT 设备产生的热能来减少碳足迹,从而确保资产的长期回报。 我以 2011 年 XNUMX 月作为我的谈话开场白 科技创业 Neil Savage 的文章“温室效应:再利用数据中心废热的五个想法”。 他在本文中引用的五个例子实际上代表了五种一般策略,因此我发现它们是探索接下来九年发展的有用起点。 这些想法是:

圣母大学数据中心为温室供暖。

雪城大学的数据中心自己发电,并在夏季使用多余的冷水为相邻办公楼提供空调,在冬季使用多余的热水供暖

苏黎世的 IBM 研究数据中心使用温水液体冷却,并使用较温暖的“回水”为相邻实验室供暖。

橡树岭国家实验室开发了一种固定在微处理器上并产生电力的装置。

巴黎的 Telecity 数据中心为气候变化影响的研究实验提供热量。

在第一部分中,我们研究了圣母大学利用数据中心废热空气来维持相邻温室度过印第安纳州北部冬季的变化。 虽然我们介绍了热空气再利用的几个不同示例案例,但一般来说,80-95°F 空气的低品位能量以及应用程序基本上邻近数据中心的要求对有吸引力的投资回报率构成了合理的障碍。 在审查使用来自 UPS 机房的 80°F 废气来减少发电机组加热器 100°F 目标的升力时,我们确定可以提供一个很好的案例,即有效的气流管理实践可以使数据中心的运行更接近ASHRAE 建议的上限会导致空气浪费,从而完全不需要发电机组加热器。 这个例子解决了能量等级和邻接障碍。 除此之外,我们发现数据中心回风热能最有效的利用发生在北欧当地的区域供热网络,并发现瑞典超过 10% 的供暖能源来自数据中心。 事实上,局部供热区以某种形式代表了有效数据中心能源再利用的有用模型,正如我们将在后续讨论中看到的那样。

我为数据中心能源再利用的第二类创造了“分流回路”,其中冷冻水回路的供应侧可以用于辅助冷却,回水侧可以用于加热或冷却。 在萨维奇文章中锡拉丘兹大学的例子中,再利用的主要能源是涡轮机废气,它的热度足以驱动吸收式制冷机提供建筑空调,从而冷却数据中心,或者热到足以运行通过热交换器在冬季为建筑物供暖。 当前“循环利用”的一颗更耀眼的明星是西雅图的威斯汀-亚马逊项目,该项目涉及更简单的工程,但在整体项目管理方面更具创造力,需要各个政府机构、公共事业和企业之间的协作,共同追求有利的自身利益。 本质上,亚马逊办公楼相当于 Clise Properties(威斯汀开利酒店的所有者)当地供热区的“客户”,Clise Properties 和 McKinstry Engineering 组建了一个注册为经批准的公用事业公司的实体。 亚马逊将避免约 80 万千瓦时的供暖能源成本,而 Clise Properties 将避免运行蒸发塔的费用以及由此产生的水损失费用。 虽然威斯汀-亚马逊模式对我来说代表了有效利用环路数据中心能源再利用项目的完美蓝图,但对麻省理工学院取消的类似项目的审查揭示了试图将所有的猫都集中起来进行此类项目的复杂性。我们将在本系列的第三部分中再次看到这一努力。

第三类数据中心热能再利用 科技创业 是热水冷却,它可以使前两类中的任何一个受益,但对于数据中心液体冷却特别有利(这最终在我们的行业中获得了一些有意义的吸引力)。 如前所述,如果数据中心废气用于促进发电机启动,将送风从 65°F 或 70°F 提高到 78-80°F 将产生足够高的回风温度,以消除块式加热器。 此外,在威斯汀-亚马逊项目中,良好的数据中心气流遏制执行可以使数据中心向公用事业热交换器的供水量增加到足以将热回收设备的升力降低28%。 在这两种情况下,我们都不是在谈论用温水或热水冷却,但即使移动针这些小步骤也可以产生显着的好处。 当我们开始使用热水时,我们会获得更高品位的废热能,并且水比空气更容易移动。

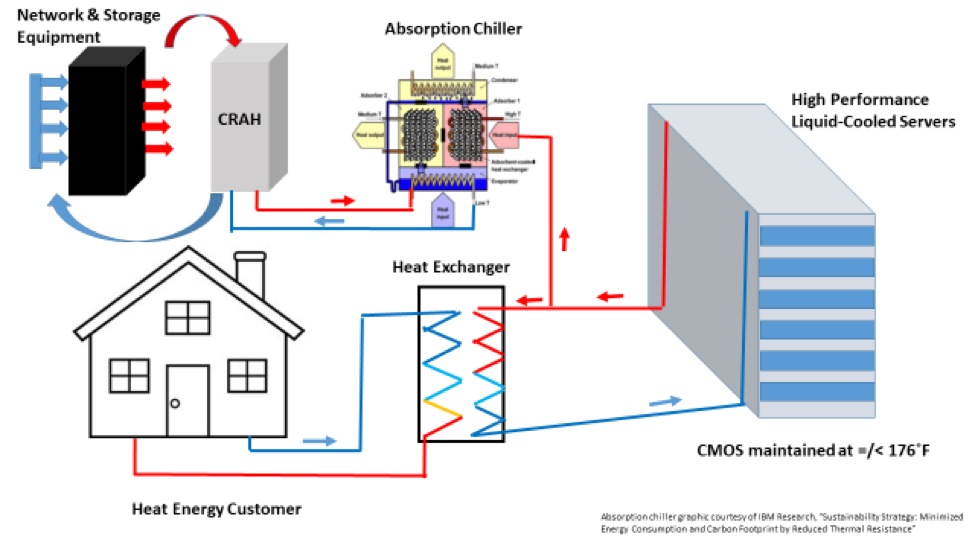

苏黎世研究实验室的 IBM 概念验证数据中心利用了直接接触液体冷却方面的创新,即通过连接到计算机芯片的铜微通道泵送热水。 他们发现 140°F 的供水将芯片温度维持在 176°F 左右,安全低于建议的最高温度 185°F。 这种热水冷却导致后处理“返回”温度为 149°F,这是通过吸收式制冷机用于建筑物供暖和冷却的足够级热能,无需热泵升压。 除了为相邻实验室提供热量外,吸收式制冷机还在约 49°F 的温度下提供 70kW 的冷却能力。 下面的图 1 展示了这种方法的简化概述。

图 1:数据中心液冷能源再利用的简化流程

大约在 IBM 热水液体冷却概念验证实验在瑞士进行的同时,eBay 正在菲尼克斯的广为人知的 Mercury 项目中进行温水冷却实验。 Mercury 项目涉及数据中心的一部分,通过连接到冷却器的冷冻水回路进行冷却,然后第二个数据中心使用来自第一个数据中心的冷凝器回水(温度高达 87°F)来供应机架安装的后门热交换器。 显然,温度超出了 ASHRAE 建议的服务器入口空气温度,但仍保持在 A2 级允许范围内。 正是在这次操作中,Dean Nelson 和他的团队提出了一个基于业务任务的数据中心效率指标,将数据中心成本与客户销售交易联系起来,从而形成了数据中心效率和有效性之间虚幻的临界点。 在这种情况下,“客户”是内部的,废热不是作为热能源而是作为冷源。

事实上,水星计划模型确实提供了低风险温水冷却的愿景,许多数据中心都可以使用这种冷却方式,而无需一直过渡到某种形式的直接接触液体冷却。 例如,使用后门热交换器的数据中心可以在 65°F 以上的供水温度下运行,这很容易超过建筑舒适冷却回水回路的回水温度。 利用回水本质上是自然冷却,然后在一年中建筑物空调可能不会连续运行的时候(或者根本不连续运行,我在明尼苏达州的朋友),后门热交换器可以通过自然冷却热交换器供电省煤器。 同样的原理也适用于直接接触液体冷却,它应该基本上可以在具有任何有意义的舒适冷却负载的任何设施中自由运行。

最近,IBM 苏黎世已将概念验证转化为苏黎世的完整生产型超级计算机 (LRZ SuperMUC-NG),并在田纳西州橡树岭开展了一个并行项目。 苏黎世实验室智能系统集成经理布鲁诺·米歇尔(Bruno Michel)声称,生产超级计算机实际上是一个负排放设施,因为所有ICT设备均由可再生能源供电,然后数据中心产生的加热和冷却就可以避免排放。 图 1 中流程中不同步骤的温度曲线将根据客户情况和要求而有所不同。 例如,为了在天气温暖且无法提供自然冷却的情况下为网络和存储设备提供冷却,并在天气凉爽时为区域供热网络提供可用的热能,数据中心的运行温度为 149°F。 为了向住宅客户提供地板采暖,温度可以降至 131°F,为了支持橡树岭的自然冷却,它们的运行温度将达到 113°F。 华氏吸收式制冷机的运行驱动温度为 127°F,可为存储和网络设备的冷却装置提供 68°F 的冷冻水,总冷却能力为 608kW。

IBM 项目依赖于降低热阻方面的突破性创新,从而允许芯片上的水温更高,从而实际提高整体芯片性能。 尽管如此,当今市场上可用的各种直接接触式液体冷却解决方案中的任何一种都可以提供热水冷却的一些显着优势。 他们都对“冷却”供水可以有多热来维持足够的芯片温度,甚至比传统空气冷却提高芯片性能提出了自己的主张。 即使这些温度可能不足以直接取代传统热源(锅炉等)或驱动吸收式制冷机,它们仍然足够高,足以显着减少热泵所需的升力,以将热量提高到有用水平。 此外,在液体冷却温度下,不需要冷却器或机械冷却。 下次我们将研究与获得热水冷却的好处相关的一些投资和运营成本权衡,以及一些更大的社会和基础设施挑战。

茉莉花 X4-Q 1040MH/s 480w

茉莉花 X4-Q 1040MH/s 480w